Una de las responsabilidades de una revista, con relación a sus autores, es la de proporcionar datos que revelen la actividad de los artículos que publica. Habitualmente, las revistas han presentado los datos de manera agregada, al nivel de las revistas. Las Métricas a Nivel de Artículo (ALMs Article Level Metrics) pretenden desagregar todos esos datos y ofertarlos por artículo, aprovechando las posibilidades de las plataformas digitales de revistas (Journal Management Systems). Estos datos son importantes para las propias revistas pues les permite obtener una información muy valiosa sobre el uso, repercusión y distribución de cada uno de los trabajos que publican y por tanto de su papel como entidades evaluadoras y difusoras de trabajos. No obstante, es especialmente útil para los autores, pues estos datos son un reflejo de la calidad de los trabajos que pueden ser (y deberían ser) usados en procesos de evaluación.

Una de las revistas pioneras en ofrecer estos datos fue Plos One (2005) que entre muchas novedades incorporó una plataforma de gestión que aprovechaba al máximo toda la información que los usuarios registraban y la repercusión de los artículos en otras plataformas (Tabla 1). De hecho, es común que se usen las métricas tradicionales de citas, con las métricas de uso web y en conjunción con métricas alternativas. Sin embargo, estas métricas fuera de contexto no tienen una medida para ser comprendidas, las métricas tienen que estar contextualizadas, relativizadas en el tiempo y en el espacio, es decir, que las citas de un artículo se deben poner en relación con las del conjunto de su revista o su categoría en el número o el año en que se publicó. Para ello, existen productos como Incites (Web of Science) o SciVal (Scopus).

Tabla 1. Métricas a Nivel de Artículo registradas por Plos One (2005)

¿Por qué las Métricas a Nivel de Artículo son importantes para la evaluación científica?

La evaluación científica del profesorado español se basa principalmente en la valoración de las publicaciones según la calidad de los medios en los que se publica, se aproxima la calidad del artículo a la calidad de la revista que lo publica. ¿Por qué? Básicamente porque apenas había información que nos ayudaba a situar la relevancia de cada trabajo, especialmente de los recién publicados. Por ello, se asumía (y asume) que publicar en una revista de calidad implicaba “competir” y “ganar” a otros trabajos para poder publicar, pues existe una relación directa entre el impacto de las revistas y sus tasas de rechazo. Por cierto, esto ya no es así con las MegaJournals, donde la competitividad por publicar teóricamente desaparece.

Es decir, que se evalúa un trabajo por la presencia de una revista en ciertas bases de datos y los indicadores promedio (Factor de Impacto, CiteScore, Scimago Journal Rank) que se genera, lo que provoca una gran desigualdad, pues sabemos que unos pocos trabajos reciben la mayor parte de las citas que posicionan a las revistas y en cambio la mayoría de los trabajos pasan sin pena ni gloria. Dicho de otra forma, un trabajo se evalúa por asociación con la calidad del medio que lo publica. ¿Qué proponen las Métricas a Nivel de Artículo? Algo simple, evaluar un trabajo de forma directa según indicadores, principalmente las citas, que han generado el propio trabajo poniéndolos en relación con el conjunto. Los indicadores a nivel de artículo son mucho más fiables y justos.

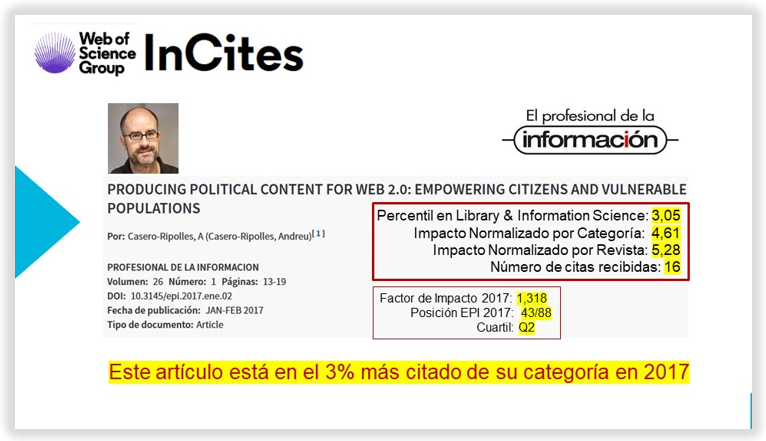

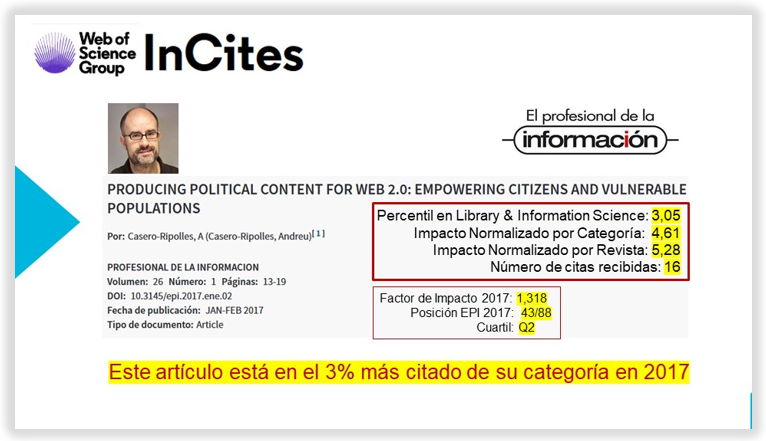

Por ejemplo; el siguiente trabajo de Andreu Casero publicado en la revista amiga “El Profesional de la Información” obtiene un número de citas elevado (16 citaS). En principio la revista EPI estaba situada en el segundo cuartil de la categoría “Library and Information Science” posición 43 de 88. Sin embargo el artículo es uno de los trabajos más citados de la revista. InCites (Web of Science) nos indica que le trabajo recibe 5.28 veces más citas que el promedio de artículos publicados en EPI en 2017. A la vez, recibe 4.61 veces más citas que los artículos publicados en el área (Library & Information Science), por lo que si ordenásemos los artículos de esa categoría ese año de más citado a menos citado el artículo escrito por Andreu Casero se situaría en el percentil 3, o dicho de otra forma; ¡este trabajo está en el 3% más citado de su categoría!

Las revistas deben preocuparse por facilitar los datos de uso de los trabajos que publican, así como de buscar otros datos como las citas en distintas plataformas y a ser posible los registros altmétricos, pero como decíamos al principio, estos datos hay que contextualizarlos para poder darles valor. Por ejemplo, esta semana, hemos publicado en Comunicar las citas relativizadas de los artículos, al objeto de que sirvan a los autores para justificar mejor la calidad de sus trabajos en convocatorias como la de Sexenios de Investigación. Sólo con la colaboración de las revistas podremos evolucionar en nuestra forma de evaluar y medir algo más cercano a la realidad, objetivo de todo proceso evaluativo.